Depuis quelques années le trafic est l’un des facteurs de performance les plus suivis des responsables de site. Son évolution est scrutée de très près et chaque baisse de trafic est souvent imputée au référencement. Pourtant, une bonne analyse permet de comprendre que trafic et SEO n’est pas la même chose. Si le référencement permet de faire évoluer votre nombre de visiteur, il n’est pas le seul levier. Votre site internet reste soumis à votre marché et à son évolution. Pour comprendre les tendances liées à votre trafic, vous devrez pousser l’analyse et étudier votre audience. Ensemble, étudions votre audience et venez découvrir si la baisse de votre trafic est un problème de SEO ?

Baisse générale du trafic

Avant de demander des comptes au responsable qui s’occupe de votre SEO, peut être serait-il bon d’analyser votre secteur d’activité. Ainsi que vote site web. La baisse générale du trafic peut provenir des spécificités de votre marché. Connaitre et comprendre vos cibles est l’une des bases de la réussite. Cela pourra vous être utile pour comprendre une baisse de trafic sur un site web.

Tendance du marché

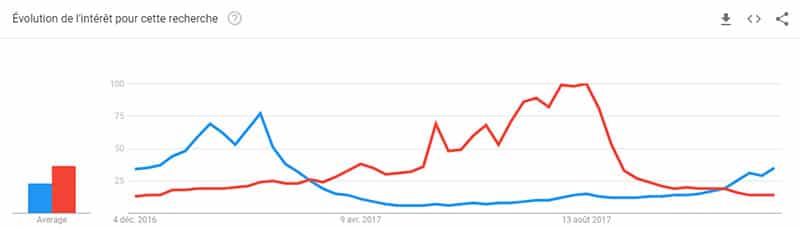

L’un des critères majeurs de l’évolution du marché est lié aux tendances. Elles peuvent être plus ou moins importantes en fonction du secteur d’activité. La saisonnalité des ventes (et souvent des recherches) en est un bon exemple. Vous pouvez avoir des pistes sur les tendances de trafic par rapport à des requêtes sur Google Trends.

Dans cet exemple vous pouvez voir les saisonnalités des recherches en fonction des périodes. Le « ski » est plus recherché en hiver et la « plage » en été. Notre exemple est volontairement simpliste. Mais on imagine facilement les évolutions du trafic sur ces périodes. Certaines stratégies SEO, voire d’entreprise peuvent déjà ressortir. Vous pouvez anticiper les baisses de trafic et de conversion de votre entreprise. Vous pouvez, par exemple, réfléchir à l’intégration de nouveaux produits/services pour compenser. C’est comme cela que l’entreprise de ski Apo Snow à testé de vendre des skateboards sur son site e-commerce.

Les saisonnalités sont des tendances clairement définies. Mais il en existe certaines moins évidentes à prendre en compte. Elles vous permettront d’adapter votre travail de génération de trafic. Ces tendances nous permettent de revenir aux fondamentaux de la stratégie digitale. Avant de lancer une activité web, vous devez analyser et comprendre vos cibles.

Évolution du marché

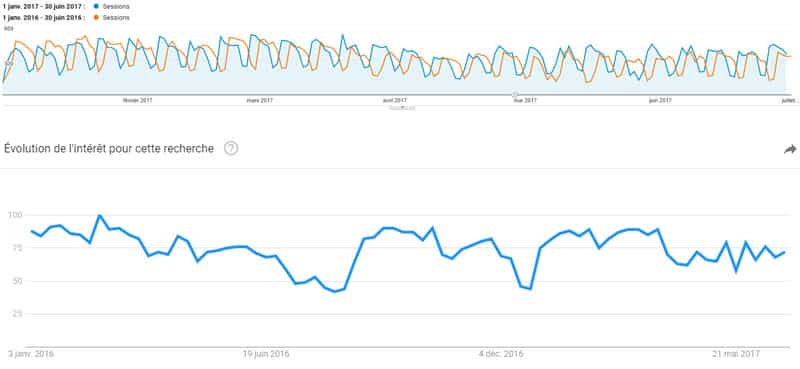

Par défaut, les résultats du SEO se comparent par rapport à des périodes précédentes. Pourtant, votre marché à forcément évolué (à la hausse ou à la baisse). C’est une information très rarement prise en compte dans les rapports d’analyses. Il est fondamental de comprendre ces évolutions et leur impact sur votre trafic. Cela vous permettra d’affiner l’analyse et pourra agrémenter les rapports SEO. Dans l’exemple ci-dessous, nous pouvons voir des recherches organiques stagnantes d’une année à l’autre. Dans le même temps, le marché à diminué. Cela laisse supposer que le travail de référencement naturel à porté ses fruits. Pourtant, le trafic du site n’a pas vraiment augmenté.

Les évolutions du marché peuvent aussi être propres à votre concurrence. Si votre entreprise n’avance pas en même temps que son marché, vos cibles risquent de perdre de l’intérêt pour votre offre. Cela se traduira naturellement par une baisse de trafic sur votre site internet.

Le piratage

Plus rare mais existants, les problèmes de sécurité peuvent être l’une des causes des baisses de trafic sur un site web. Dès lors où vous avez été piraté, vous perdrez fatalement une partie de votre audience, redirigé vers d’autres sites. De plus, les moteurs de recherche vont réagir lorsque vos pages seront crawlées. Pour repérer ces problèmes, trois solutions s’offrent à vous. En premier lieu, rendez vous régulièrement sur votre compte Google Search Console. Vous pourrez y trouver un message si Google a repéré un piratage. Vous pouvez aussi créer une veille active sur cette thématique. Pour cela créez des alertes sur Google Alertes. Ici, l’idée est de mettre une veille sur votre nom de domaine + des termes liés au piratage (casino, termes pornographiques, vente en ligne,…). La dernière façon de détecter une baisse de trafic lié au piratage et de naviguer manuellement sur le site.

Si vous souhaitez en savoir plus sur la sécurité nous vous conseillons la lecture de notre article : Le guide complet pour sécuriser votre site WordPress

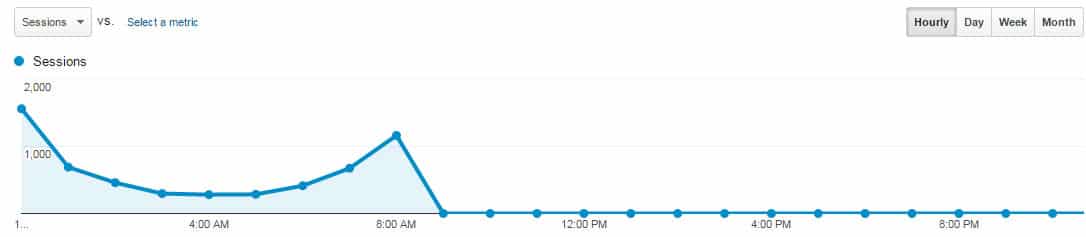

Panne d’hébergement

L’hébergement peut être une source de baisse de trafic importante. Il vous faudra alors réagir rapidement. Car les pannes d’hébergeurs ou les manquements de paiement peuvent avoir des conséquences importantes. Si votre site n’est plus accessible pendant une longue période, vous n’aurez plus aucun trafic. Malheureusement, il se peut que vous ne vous en rendiez pas compte. Si vous êtes soumis à une panne d’hébergement et quelle est résolue rapidement. Généralement, cela se traduit par une cassure de votre courbe de trafic dans Google Analytics.

Mauvais paramétrage Google Analytics

Le paramétrage de Google Analytics est l’un des points clés d’une stratégie SEO. Pourtant, la plupart des sites se contentent de poser le script et de piloter leur activité avec des donnés incomplètes. Voire fausses. Paramétrer un compte GA demande une certaine expertise. Dans le cas d’une baisse de trafic constaté, ce ne seront pas les résultats qui seront impactés mais plutôt l’analyse. Un expert SEO doit être capable d’identifier assez rapidement ce genre de problématique. En général, cela peut provenir de plusieurs facteurs :

- Le code de suivi n’est pas ou plus présent sur certaines pages, voir sur l’ensemble du site.

- Le code de suivi n’est pas le bon (pour les entreprises ayant plusieurs codes de suivi).

- Mauvaise configuration de l’outil qui ne remonte qu’une partie des données

Pour palier à des problèmes liés au paramétrage de GA, nous vous conseillons l’outil Google Analytics checker. Il va crawler toutes les pages de votre site web et faire remonter les marqueurs d’analyse présents. Vous aurez ainsi une vision des pages non suivies. Autre outil incontournable du SEO, Screaming Frog. Il vous permet de suivre les pages contenant le script GA dans votre site. Pour cela suivez la procédure suivante (Si vous avez un abonnement) :

Configuration > Custom > Search et intégrer deux filtres en renseignant pour chaque le code de suivi Analytics. Un filtre sera configuré sur « contain » et un autre sur « does not contain ».

Baisse de trafic liée au SEO

Bien entendu, une baisse de trafic peut tout à fait être liée à des problématiques SEO. Si vous constatez une chute significative dans Google Analytics, vous devez agir. Commencez par vérifier que cela provient du canal « recherche organique ». Si c’est votre cas, découvrez les causes de ces chutes de trafic. Cela vous aidera à mettre en place les actions correctives. Et ainsi vous permettre de reprendre vos positions sur votre marché.

La concurrence

La concurrence est très souvent mise de côté dans les analyses de référencement naturel. Si vous ne travaillez pas votre SEO, vous vous exposez aux réactions des entreprises de votre secteur. Elles peuvent mettre en place leurs propres actions webmarketing. Et ainsi prendre des positions sur des mots clés générant du trafic sur votre site. Soit par le biais d’actions SEO ou d’actions SEA.

Le SEO

Le positionnement SEO est dû à plusieurs facteurs. Pour bien comprendre le référencement naturel, il faut comprendre que le positionnement se travaille par mot clé. Vous pouvez être bien positionné sur certaines expressions et moins bien sur d’autre. En investissant, vos concurrents peuvent reprendre des positions sur des mots clés à votre détriment. Certains concurrents se placent sur la position 0 et accaparent une partie de l’audience.

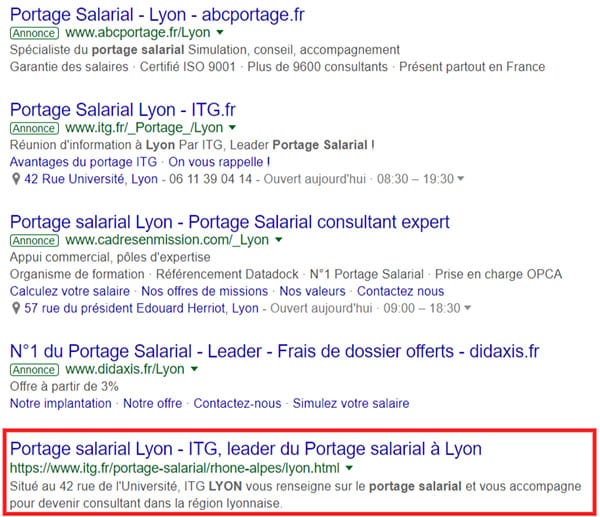

Le SEA

Le référencement payant est aussi un facteur de baisse de trafic pour votre entreprise. Cela peut paraitre flou, pourtant la logique est assez simple. Certains mots clés n’ont pas de concurrence payante. Vous avez par défaut un meilleur positionnement. Mais vos concurrents peuvent mettre en place des campagnes SEA. Vous allez naturellement perdre des positions et donc du trafic sur ce(s) mot(s) clé(s). Dans cet exemple, vous pouvez voir la première requête SEO dans Google :

Outil de suivi des positions

Les outils de suivi des positions vous permettent d’analyser si votre baisse de trafic est dûe à une perte de position sur vos mots clés. Ils vous donneront accès à des metrics comme la position dans les moteurs de recherche par mot-clé. Les évolutions de positionnement. Et, dans certains cas, les informations concurrentielles. Il existe de nombreux outils de suivi de positionnement. Nous pouvons vous en conseiller certains tels que Monitorank ou encore SeeURank. Attention tout de même à tester ces outils avant de faire votre choix. Vous devez valider leur adéquation avec vos besoins.

Concernant votre baisse de trafic, deux cas de figure sont envisageables :

- Vous avez perdu quelques positions sur des mots clés ciblés. Normalement, vous devriez pouvoir les reprendre en optimisant les pages correspondantes.

- Vous analysez une baisse générale de vos positions sur votre marché. Il faudra aller plus loin dans l’analyse, ainsi que dans les actions à mettre en place. Voici un aperçu des points à prendre en compte.

Crawl des pages et indexation de contenu

L’un des problèmes récurrents en SEO qui peut expliquer une baisse de trafic provient de la technique. Les pages de votre site internet peuvent exister mais ne pas être accessibles par les moteurs de recherche. C’est le crawl et l’indexation des pages. Ces deux points sont souvent confondus. Pourtant, dans le processus SEO, ce ne sont pas les mêmes étapes. Vous devrez donc les analyser et les traiter différemment.

Le crawl des pages de votre site

Pour pouvoir proposer votre contenu à un moteur de recherche, il doit pouvoir accéder à vos pages. En imageant le processus, des robots passent de page en page et « aspirent » votre contenu pour l’analyser puis l’indexer. Seulement voilà, pour pouvoir faire ce travail, les robots doivent avoir accès à vos pages. Et dans les faits, pour crawler une page, il est nécessaire que des liens mènent à celle-ci. Dans le cas contraire, vos pages sont isolées et les moteurs de recherche ne pourront pas y accéder. Donc, impossible de crawler vos pages. Vous devez avoir travaillé l’arborescence de votre site web pour que vos pages soient accessibles.

Vous trouverez dans votre Search Console des indications sur le crawl de votre site. Plus votre site est important et plus il est difficile pour les moteurs de recherche de crawler vos pages. L’objectif est d’avoir un taux de crawl élevé qui amènera à une meilleure indexation et donc un bon référencement de vos pages.

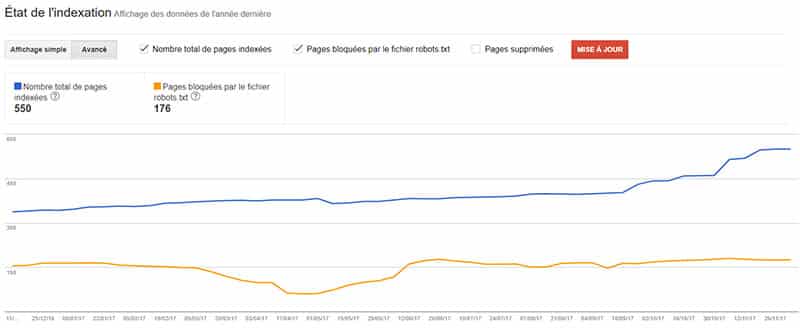

L’indexation des pages de votre site web

C’est la base du travail de référencement naturel. Il n’y a pas de SEO si vos pages ne sont pas indexées. Concrètement, une fois vos pages sont crawlées, elles pourront être indexées. L’indexation des pages de votre site web signifie que les moteurs de recherche les ont prises en compte et les présentent dans leur index. Attention, on ne parle pas ici de position mais uniquement de présence. Vous aurez donc bien compris que de travailler tous les aspects du SEO d’une page qui n’est pas indexée ne sert à rien ?

Vous pouvez vérifier l’indexation de vos pages, dans votre Search Console. Index Google/État de l’indexation

Vous pouvez aussi utiliser un crawler qui vous donnera des indications. Vérifiez les erreurs d’indexation. Regardez aussi les balises méta « no index » ainsi que les url’s canoniques redirigées vers des pages 404.

Mise à jour de votre site

En référencement naturel, les mises à jour peuvent être un facteur important de baisse de trafic. Les évolutions qui ont pour objectif de favoriser le SEO du site peuvent être mal réalisées ou mal orientées. Il peut aussi y avoir des conflits entre les outils. Une chute de trafic suite à une mise à jour technique ou éditoriale, doit vous alerter. Analysez les modifications apportées. Nous vous conseillons de baliser votre compte GA lors de modification.

Les mises à jour techniques

La diminution de votre trafic peut s’expliquer par des mises à jour techniques. Évolution de votre CMS vers une version pas stable, intégration de nouveaux plugins, passage de votre site en https. Ce sont autant de facteurs, qui, mal maitrisés peuvent entrainer des conséquences en SEO :

- Accès à une partie du site interrompu

- Création de contenu dupliqué

- Création d’erreurs 404

- Temps de chargement des pages plus important

Certaines actions techniques doivent être accompagnées par des professionnels. Cela évite de perdre vos positions SEO. Par exemple, nous vous conseillons de ne pas effectuer le passage en https tout seul. Cela demande de mettre en place des redirections afin de garder la popularité des pages. Vous devrez ensuite paramétrer vos comptes Google Analytics et Search Console.

Les mises à jour de contenu

Mettre à jour votre contenu peut aussi être une source de baisse de trafic. Lorsque vous travaillez vos pages, vous pouvez perdre des positions sur certains mots-clés. Ces pertes peuvent être dûes, entre autre, à :

- La modification d’url’s sans faire les redirections

- La diminution du volume du mot clé principal

- La déstructuration de la page

- La diminution du nombre de mots dans la page

- Le travail sur le linking et le maillage interne (attention aux erreurs 404)

Vous pouvez suivre l’évolution de vos positions dans l’un des outils de suivi des positions que nous vous avons cité plus haut.

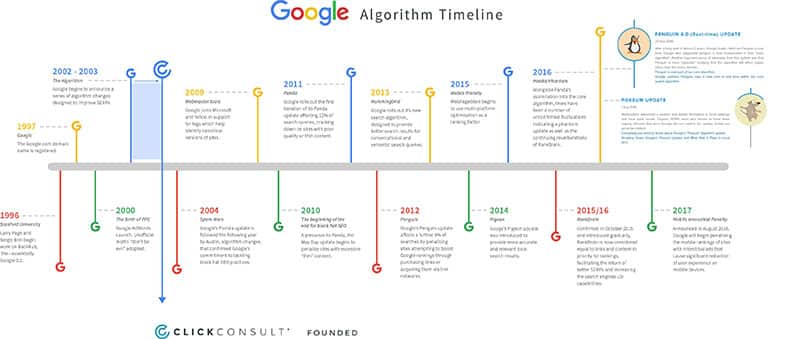

Mise à jour des algorithmes des moteurs de recherche

C’est un élément de plus en plus fréquent à prendre en compte dans la stratégie SEO de votre entreprise. Les mises à jour des algorithmes des moteurs de recherche se font plus fréquentes et la tendance n’est pas à la baisse. L’objectif est de proposer un outil intuitif et répondant au mieux aux demandes des utilisateurs. Vous aurez certainement entendu parler des deux mises à jours majeures de Google que sont Pingouin et Panda. Mais ce ne sont pas les seules. Voici un résumé réalisé par Click Consult

Vous pouvez aussi retrouver l’ensemble des MAJ Google sous forme de timeline chez rankwatch. Comme vous pouvez le constater, les mises à jour sont très nombreuses. Elles vont vous demander une certaine capacité d’adaptation. Ces mises à jour régulières risquent de pénaliser les sites les plus anciens ou les sites les plus pauvres techniquement.

Perte de liens

C’est un axe critique du référencement naturel. Le linking (ou netlinking) est l’un des piliers de toute stratégie SEO. C’est par le biais des liens entrants sur votre site web que les moteurs de recherche sont capables de définir votre popularité. C’est aussi par ce biais qu’ils vous feront remonter plus facilement sur un mot clé par rapport à un concurrent. Par conséquent, perdre des liens risque fortement de nuire à votre SEO.

Pour suivre l’évolution des liens pointant vers votre domaine, vous pouvez utiliser des outils. Il en existe de nombreux, tels que Majestic SEO ou encore Xenu. Ils vous permettront de créer des reportings et d’analyser l’évolution de vos liens sur votre site web. Ainsi, en cas de perte de liens en nombre, ou de liens de qualité, vous pourrez mettre en place une stratégie de récupération. Pour cela, n’hésitez pas à vérifier les pages qui effectuaient un lien et à comprendre pourquoi celui-ci à disparu. Vous pourrez ensuite prendre contact avec l’administrateur du site. Soit pour échanger avec lui afin de récupérer un lien, soit pour le mettre en garde sur un problème technique sur sa page (et ainsi récupérer votre lien).

Contenu dupliqué

La problématique du contenu dupliqué (où duplicate content pour les néophytes) est assez récurrente en SEO. Dans les faits, le contenu dupliqué est le fait d’avoir un même contenu accessible par des url’s différentes. Cela signifie avoir deux fois la même information à des endroits différents. Dans les faits, les moteurs de recherche pénalisent ces pratiques. La logique est assez simple. Indexer une page demande des ressources en bande passante et coûte donc de l’argent. Inutile donc d’indexer une page qui n’a pas de plus values complémentaires par rapport à une autre. On considère que pour ne pas pénaliser une page, environ 50% du contenu doit être différent d’une autre. Mais il n’y a pas de règle universelle. Le contenu dupliqué peut être de deux types.

Le duplicate content externe

La première façon de créer du contenu dupliqué et de copier, ou de se faire copier des pages par rapport à un autre site web. Si vous avez copié les contenus d’un site, vous devrez donc modifier ce que vous avez récupéré. En dehors du fait que c’est illégal pour des notions de droit d’auteur, cela risque de pénaliser l’ensemble de votre site. Si le problème provient d’un site qui a récupéré vos contenus. Dans ce cas, contacter directement l’administrateur du site pour lui demander de retirer la page ou de la modifier. En cas de refus, Google propose un outil de suppression de contenu. Mais ne vous faîtes pas trop d’illusion quant à cette solution. Sinon, il vous reste les recours légaux.

Le duplicate content interne

Deuxième possibilité, vous avez crée vous-même du contenu dupliqué sur votre site. Cela peut être dû au CMS utilisé qui peut avoir tendance à créer des pages complémentaires. C’est aussi une problématique que l’on retrouve souvent en e-commerce. Notamment avec les produits similaires pour lesquelles il n’a pas été défini d’url canonique (url référente pour faire simple).

Pour vérifier si vous avez du contenu dupliqué, vous pouvez utiliser certains outils en ligne tel que Siteliner. Pour les plus petits sites vous pouvez regarder à l’aide de la commande « site:www.monsite.com » de Google. Cela vous donnera l’ensemble des pages indexés de votre site. Pour régler le problème, plusieurs solutions sont identifiables.

Pénalité manuelle Google

Aussi étonnant que cela puisse paraitre, Google n’est pas qu’un robot. C’est aussi des hommes qui travaillent à l’amélioration continue du moteur de recherche. C’est donc dans cette optique que certains salariés de la firme parcourent le web. Ils vérifient l’application des bonnes pratiques définies par le W3C, ainsi que par Google lui-même. Ils ont la possibilité d’infliger une pénalité manuellement qui risque fort de provoquer une baisse de trafic drastique à votre site web. Vous pourrez vous en rendre compte dans le menu « action manuelle » de la Search Console. Un message apparaitra pour vous donner les raisons de la pénalité. Cela vous permettra de le résoudre et de demander une réévaluation de votre site.

SEO Black Hat et negative SEO

Dernier élément qui peut expliquer une baisse de trafic SEO, les actions de référencement qui vont à l’encontre des moteurs de recherche. Car si nous prônons de manière générale un SEO propre et qui repose sur le suivi des règles éditées, il existe aussi le penchant inverse. Tout aussi efficace, mais qui demande une expertise très spécifique. Le problème de ces techniques très « borderline » réside principalement dans le fait qu’une fois dans la spirale, on ne peut plus en sortir.

Le SEO black hat

Le SEO black est l’extrême opposé de tout ce que nous pouvons proposer sur la Pousse Digitale. L’objectif est de faire affoler les compteurs en termes de trafic. Comment ? En se servant des faiblesses des algorithmes des moteurs de recherche. Dans les faits, cela se traduit souvent par de la recherche de liens continuels en masse. Si ces techniques apportent de vrais résultats sur le court terme, elles sont aussi limitées dans le temps. Car si les moteurs de recherche réussissent à vous rattraper, vous pouvez être sûr que votre site sera pénalisé à vie.

Le négative SEO

Dans le même esprit, le négative SEO consiste à s’attaquer à un site tiers en essayant de détruire sa stratégie de référencement. Pour cela, les attaquants travaillent deux axes majeurs :

- Le netlinking en créant des backlinks en masse de très mauvaise qualité

- Le duplicate content, en copiant volontairement des pages de votre site.

Si vous êtes victime de ce type d’attaque, vous pouvez désavouer les liens non voulus. Il vous faut pour cela suivre les liens entrants régulièrement. Et vous servir de l’outil de désaveu de liens de Google.

Comprendre votre baisse de trafic

Pour appréhender comme il faut une baisse de trafic, vous vous devez de l’analyser. Pour cela, votre meilleur ami reste encore Google Analytics. Il vous permettra de comprendre si la chute du trafic est localisée sur des pages (ou des mots clés) ou si elle est généralisée. Vous pourrez alors mettre en place les actions correctives.

Attention toutefois. Pour être tout à fait exhaustif, vous devez avoir une vision globale de votre stratégie web. Le SEO n’est qu’un des canaux de génération de trafic et pour vérifier la concordance de vos actions, vous devrez avoir un visuel sur l’ensemble de ces canaux.

Baisse de trafic versus baisse de résultat

Afin de compléter notre article et pour être tout à fait exhaustif, nous devons aborder un dernier point. Et non des moindres. L’objectif premier de la mise en place d’une stratégie digitale n’est pas de générer du trafic. Le web est un outil commercial qui vous permet de convertir des prospects en clients. Que se soit en e-commerce, ou pour la génération de leads, vous devez d’abord vous concentrer sur le retour sur investissement (ROI) lié au web. Et dans ce domaine, baisse de trafic et baisse de résultats ne sont pas nécessairement imbriquées. Si vous définissez une stratégie SEO visant à attirer une audience qualifiée, vous risquez de diminuer le volume de recherche. Pour autant, vous vous concentrerez sur une cible plus proche de l’acte d’achat.

Voici un exemple de positionnement volume vs conversion :

Prenons le cas d’une agence de voyage qui souhaite positionner une page

Hypothèse 1 : voyage

Hypothèse 2 : agence de voyage

Hypothèse 3 : agence de voyage pour vacances pas cher aux Maldives en juillet 2018

Vous aurez compris que plus nous avançons dans les hypothèses, et moins le volume de recherche est important. Pourtant, la capacité des pages à convertir leur audience est de plus en plus importante. C’est la théorie de la longue traine marketée pour convertir.

Votre Kpi premier devra donc bien être le chiffre d’affaires que vous génère votre site web avant de parler de trafic.